Методы сбора и анализа информации в управленческой деятельности

Прагматический подход определяет количество информации как меру, способствующую достижению поставленной цели. Одной из первых работ, реализующих этот подход, была статья А. А. Харкевича. В ней он предлагал принять за меру ценности информации количество информации, необходимое для достижения поставленной цели. Этот подход базируется на статистической теории Шеннона и рассматривает количество… Читать ещё >

Методы сбора и анализа информации в управленческой деятельности (реферат, курсовая, диплом, контрольная)

В самом общем виде методы сбора информации, которые применяются в сфере управления, можно разделить на две группы: промышленный шпионаж и аналитическая работа. Первый из приведенных методов — промышленный шпионаж — в основном относится к получению конфиденциальной информации и будет рассмотрен позже, а в данной главе уделим внимание аналитической работе.

В условиях постоянно изменяющихся экономических отношений, образования новых организаций, развития и совершенствования уже работающих на рынке организаций-конкурентов возникает большая потребность в проведении аналитической работы. Появляется необходимость сбора и накопления информации, опыта, знаний во всех областях управленческой деятельности. Организация заинтересована в подробном исследовании возникающих на рынке ситуаций для принятия оперативных, экономически обоснованных решений, которые позволят ей развиваться более быстрыми темпами.

Анализ является одним из наиболее эффективных и безопасных способов добывания информации. Используя открытые информационные ресурсы, можно получить практически все необходимые сведения об организации. Процесс получения важных сведений на основе синтеза информации из множества открытых источников будем называть аналитической работой. Она состоит из следующих этапов.

Определение круга исходной информации, необходимой для анализа, а также способов ее получения.

Интерпретация информации, т. е. выявление истинного значения той или иной информации. В первую очередь в интерпретации нуждается информация, полученная в устной форме, так как часто то или иное высказывание бывает понято превратно, причиной тому могут стать иностранная речь, интонация, жесты, слэнг, фразы, вырванные из контекста либо неправильно понятые, и т. п.

Выделение посторонней информации — один из самых сложных и ответственных этапов. Избыток информации, так же как и ее недостаток, представляет собой серьезную проблему, затрудняет и замедляет ведение аналитической работы. На практике бо? льший эффект приносит сосредоточенность на нескольких ключевых деталях, чем разбрасывание между многими разрозненными данными. Вместе с тем именно на этом этапе существует опасность потерять важную информацию. Как правило, это происходит в случае неправильной интерпретации сведений на предыдущем этапе.

Оценка информации — расстановка источников информации, самой информации и способов ее получения в зависимости от их надежности и достоверности. Источником информации могут быть конкретные люди, газеты, телевидение, сайты сети Интернет и т. п. При оценке информации обязательно присутствует субъективность, которую необходимо свести к минимуму. Как правило, для этого применяют следующую систему оценок.

1. Оценка источника:

А — надежный;

Б — обычно надежный;

В — довольно надежный;

Г — не всегда надежный;

Д — ненадежный;

Е — источник неустановленной надежности.

2. Оценка информации:

I — подтвержденная другими фактами;

II — вероятно правдивая (правдива на 75%);

III — возможно правдивая (правдива на 50%);

IV — сомнительная (правдива на 25%);

V — неправдоподобная;

VI — достоверность не поддается определению.

3. Оценка способа получения информации:

I — получение информации самостоятельно (видел, слышал сам и т. п.);

II — получение информации через постоянный источник (информатор, открытые источники и т. п.);

III — получение информации через разовый источник (случайно подслушанный разговор, слухи и т. п.).

На этапе оценки необходимо установить, насколько информация может соответствовать истине. При этом следует учитывать, что можно получить не соответствующую истине информацию следующих типов:

- • дезинформация, доведенная до сведения источника;

- • информация, преднамеренно или непреднамеренно искаженная источником;

- • информация, произвольно или непроизвольно измененная в ходе передачи.

При намеренной дезинформации применяются заведомая ложь, полуправда, а также правдивые сведения, которые в данном контексте подтолкнут воспринимающего информацию к ложным выводам. Искажения, возникающие в процессе передачи информации, могут происходить по нескольким причинам:

- • передача только части сообщения;

- • пересказ услышанного своими словами;

- • субъективное восприятие фактов.

Для своевременного выявления искаженной информации, а также для предотвращения дезинформации необходимо различать факты и мнения, учитывать субъективные характеристики источника информации и его предполагаемое отношение к выдаваемому сообщению. Следует четко осознавать, способен ли источник информации по своему положению иметь доступ к сообщаемым фактам. Для страховки необходимо иметь дублирующие источники, использовать дублирующие каналы связи и стараться исключать лишние промежуточные звенья передачи информации. Кроме того, следует помнить, что особенно легко воспринимается дезинформация, которая хорошо соответствует принятой ранее версии, т. е. та, которую предполагают или желают получить.

Построение предварительных версий — этап аналитической работы, объясняющий место основных полученных фактов в цепи событий. Здесь необходимо выделить ключевые моменты, отделить их от менее важных, не играющих главной роли. Полученные сведения должны быть четко классифицированы по степени достоверности источника, самих сведений и способа их получения. В первую очередь должны рассматриваться самые свежие и полные сведения. Материалами с пометками «источник неустановленной надежности» и «достоверность не поддается определению» не рекомендуется пользоваться без крайней необходимости.

Затем необходимо выявить все возможные гипотезы, которые могут объяснять ключевые события, и, расположив их по степени вероятности, поочередно проверять на стыкуемость со всеми данными. Если обнаружено значительное расхождение предварительной гипотезы с полученными сведениями, причем последние имеют достаточно высокие оценки достоверности, то следует переходить к следующей гипотезе. Таким образом, выбираются наиболее вероятные предположения.

На этом этапе возникает одна из самых серьезных проблем анализа — противоречия в сведениях. Для ее преодоления необходимо сравнить оценки информации и источника, даты получения спорных сведений. Решающее же значение имеют знания, опыт и интуиция сотрудника, выполняющего анализ. Противоречия в информации должны быть устранены в процессе анализа, для этого собирается дополнительная информация.

Определение потребности в дополнительной информации означает решение вопроса о том, какая именно информация необходима. На этом этапе выявляются пробелы в информации. При этом следует учитывать, что часть пробелов обнаруживается достаточно легко, так как является результатом недостаточного исследования. Другие пробелы могут и не быть обнаружены, потому что были упущены на этапе предварительных сведений. Очевидно, что они являются болезненными.

Когда пробелы в информации выявлены, определяется их важность для дальнейшего анализа. Если получение дополнительных сведений признано необходимым, все описанные выше этапы повторяются. Хотя это может происходить многократно, на определенном этапе придется ограничиться имеющимися данными и оформить полученные выводы в виде отчета. На основании аналитических отчетов, справок, обзоров разного рода руководители высшего ранга принимают важные решения, значительная часть которых относится непосредственно к управленческой деятельности. К методам сбора конфиденциальной коммерческой информации предпринимателей-конкурентов относится получение сведений из испорченных и выброшенных документов, черновиков, копировальной бумаги, испорченных дискет и т. п. С одной стороны, они могут нести в себе ценнейшую информацию, и, с другой стороны, в этом нет ничего противозаконного. Кроме того, получение важной информации легальным путем возможно и при научно-техническом сотрудничестве по интересующей тематике, анализируя оговорки на совместных семинарах, конференциях и т. п.

Для того чтобы оценить и измерить количество информации в соответствии с вышеизложенными аспектами, применяются различные подходы и методы. Среди них выделяются статистический, семантический, прагматический и структурный. Исторически наибольшее развитие получил статистический подход.

Статистический подход изучается в обширном разделе кибернетики, называемом теорией информации. Основоположником этого подхода считается К. Шеннон, опубликовавший в 1948 г. свою математическую теорию связи. Большой вклад в теорию информации до него внесли ученые Найквист и Хартли, которые соответственно в 1924 и 1928 гг. напечатали работы по теории телеграфии и передаче информации. Признаны во всем мире исследования по теории информации российских ученых А. Н. Колмогорова, А. Я. Хинчина, В. А. Котельникова, А. А. Харкевича и др.

К. Шенноном было введено понятие количества информации, снимаемой при получении информации, как меры неопределенности состояния системы. Количественно выраженная неопределенность состояния получила название энтропии по аналогии с подобным понятием в статистической механике. При получении информации уменьшается неопределенность, т. е. энтропия, системы. Очевидно, что, чем больше информации получает наблюдатель, тем больше снимается неопределенность, и энтропия системы уменьшается. При энтропии, равной нулю, о системе имеется полная информация, и наблюдателю она представляется целиком упорядоченной. Таким образом, получение информации связано с изменением степени неосведомленности получателя о состоянии этой системы.

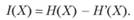

До получения информации ее получатель мог иметь некоторые предварительные (априорные) сведения о системе X. Оставшаяся неосведомленность и является для него мерой неопределенности состояния системы (энтропией). Обозначим априорную энтропию системы X через Н (Х). После получения некоторого сообщения наблюдатель приобрел дополнительную информацию 1(Х), уменьшившую его начальную неосведомленность так, что апостериорная (после получения информации) неопределенность состояния системы стала Н'(Х).

Тогда количество информации может быть определено как.

(1.1).

(1.1).

Другими словами, количество информации измеряется уменьшением (изменением) неопределенности состояния системы.

Если апостериорная энтропия системы обратится в ноль, то первоначально неполное знание заменится полным и количество информации, полученной в этом случае наблюдателем, будет.

(1.2).

(1.2).

т.е. энтропия системы может рассматриваться как мера недостающей информации.

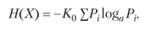

Если система X обладает дискретными состояниями (т.е. переходит из состояния в состояние скачком), их количество равно N, а вероятность нахождения системы в каждом из состояний — Р1, Р2, Р3, …, РN, то согласно теореме Шеннона энтропия системы.

(1.3).

(1.3).

Здесь коэффициент К0 и основание логарифма а определяют систему единиц измерения количества информации. Логарифмическая мера информации была предложена Хартли для представления технических параметров систем связи как более удобная и более близкая к восприятию человеком, привыкшим к линейным сравнениям с принятыми эталонами. Например, каждый чувствует, что две однотипные дискеты должны обладать вдвое большей емкостью, чем одна, а два идентичных канала связи — иметь удвоенную пропускную способность. Знак минус в формуле (1.3) поставлен для того, чтобы значение энтропии было положительным.

Энтропия H обладает рядом интересных свойств. Вот некоторые из них.

Энтропия H равна нулю только тогда, когда все вероятности Р, кроме одной, равны нулю, а эта единственная вероятность равна единице. Таким образом, H = 0 только в случае полной определенности состояния системы.

При заданном числе состояний системы N величина H максимальна и равна К0 log0 TV, когда все Р равны.

Определим единицы измерения количества информации с помощью выражения для энтропии системы с равновероятными состояниями.

Пусть система имеет два равновероятных состояния, т. е. N = 2. Будем считать, что снятие неопределенности о состоянии такой системы дает одну единицу информации, так как при полном снятии неопределенности энтропия количественно равна информации H = 1. Тогда.

(1.4).

(1.4).

Очевидно, что правая часть равенства будет тождественно равна единице информации, если принять К0 = 1 и основание логарифма а = 2. В общем случае при N равновероятных состояний количество информации.

(1.5).

(1.5).

Выражение (1.5) получило название формулы Хартли и показывает, что количество информации, необходимое для снятия неопределенности о системе с равновероятными состояниями, зависит лишь от количества этих состояний.

Информация о состояниях системы передается получателю в виде сообщений, которые могут быть представлены в различной синтаксической форме, например в виде кодовых комбинаций, использующих т различных символов и п разрядов, в каждом из которых может находиться любой из символов. Если код не избыточен, то каждая кодовая комбинация отображает одно из состояний системы. Количество кодовых комбинаций будет N = тn.

Подставив это выражение в формулу (1.5), получим.

(1.6).

(1.6).

Если код двоичный, т. е. используются лишь два символа (0 или 1), то т = 2 = п. В этом случае количество информации в сообщении составит п двоичных единиц, называемых битами (binary digit (bit) — двоичная цифра).

При использовании в качестве основания логарифма числа десять единицы измерения информации могут быть десятичными. Так как log2N = log10N/log102 = 3,321og10N, то десятичная единица составляет примерно 3,33 бита.

Иногда удобно применять натуральное основание логарифма — е. В этом случае получающиеся единицы информации называются натуральными, или нотами. Переход от основания а к основанию А требует лишь умножения на logAa.

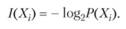

Введенная количественная статистическая мера информации широко используется в теории информации для оценки собственной, взаимной, условной и других видов информации. Рассмотрим в качестве примера собственную информацию, под которой будем понимать информацию, содержащуюся в данном конкретном сообщении. А конкретное сообщение, как указывалось, дает получателю информацию о возможности существования конкретного состояния системы. Тогда количество собственной информации, содержащееся в сообщении Xi, определяется как.

(1.7).

(1.7).

Собственная информация имеет следующие свойства: она неотрицательна; чем меньше вероятность возникновения сообщения, тем больше информации оно содержит. Именно поэтому неожиданные сообщения так воздействуют на психику человека, что содержащееся в них большое количество информации создает информационный психологический удар, иногда приводящий к трагическим последствиям; если сообщение имеет вероятность возникновения, равную единице, то информация, содержащаяся в нем, равна нулю, так как заранее известно, что может прийти только это сообщение, а значит, ничего нового потребитель информации не получает; собственная информация обладает свойством аддитивности, т. е. количество собственной информации нескольких независимых сообщений равно их сумме.

Следует еще раз отметить, что статистический подход к количественной оценке информации был рассмотрен для дискретных систем, случайным образом переходящих из состояния в состояние, и, следовательно, сообщение об этих состояниях также возникает случайным образом.

Кроме того, статистический метод определения количества информации практически не учитывает семантического и прагматического аспектов информации.

Семантический подход является наиболее трудно формализуемым и до сих пор окончательно неопределившимся.

Наибольшее признание для измерения смыслового содержания информации получила тезаурусная мера, предложенная Ю. И. Шнейдером. Идеи тезаурусного метода были сформулированы еще основоположником кибернетики Н. Винером. Для понимания и использования информации ее получатель должен обладать определенным запасом знаний.

Если индивидуальный тезаурус потребителя отражает его знания о данном предмете, то количество смысловой информации, содержащееся в некотором сообщении, можно оценить степенью изменения этого тезауруса, произошедшего под воздействием данного сообщения. Очевидно, что количество информации нелинейно зависит от состояния индивидуального тезауруса пользователя, и хотя смысловое содержание сообщения постоянно, пользователи, имеющие отличающиеся тезаурусы, будут получать неодинаковое количество информации.

В самом деле, если индивидуальный тезаурус получателя информации близок к нулю, то в этом случае и количество воспринятой информации равно нулю.

Иными словами, получатель не понимает принятого сообщения, и, как следствие, для него количество воспринятой информации равно нулю. Такая ситуация эквивалентна прослушиванию сообщения на неизвестном иностранном языке. Несомненно, сообщение не лишено смысла, однако оно непонятно, а значит, не имеет информативности.

Количество семантической информации в сообщении также будет равно нулю, если пользователь информации абсолютно все знает о предмете, т. е. его тезаурус, и сообщение не дает ему ничего нового.

Интуитивно чувствуется, что между этими полярными значениями тезауруса пользователя существует некоторое оптимальное значение, при котором количество информации, извлекаемое из сообщения, становится для получателя максимальным.

Тезаурусный метод подтверждает тезис о том, что информация обладает свойством относительности и имеет, таким образом, относительную, субъективную ценность. Для того чтобы объективно оценивать научную информацию, появилось понятие общечеловеческого тезауруса, степень изменения которого и определяет значительность получаемых человечеством новых знаний.

Прагматический подход определяет количество информации как меру, способствующую достижению поставленной цели. Одной из первых работ, реализующих этот подход, была статья А. А. Харкевича. В ней он предлагал принять за меру ценности информации количество информации, необходимое для достижения поставленной цели. Этот подход базируется на статистической теории Шеннона и рассматривает количество информации как приращение вероятности достижения цели. Так, если принять вероятность достижения цели до получения информации равной Р0, а после ее получения — Р1, то прагматическое количество информации Iп определяется как.

(1.8).

(1.8).

Если основание логарифма сделать равным двум, то Iп будет измеряться в битах, как и при статистическом подходе.

При оценке количества информации в семантическом и прагматическом аспектах необходимо учитывать и временную зависимость информации. Дело в том, что информация, особенно в системах управления экономическими объектами, имеет свойство стареть, т. е. ее ценность со временем падает, и важно использовать ее в момент наибольшей ценности.

Структурный подход связан с проблемами хранения, реорганизации и извлечения информации и по мере увеличения объемов накапливаемой в компьютерах информации приобретает все большее значение.

При структурном подходе абстрагируются от субъективности, относительной ценности информации и рассматривают логические и физические структуры организации информации. С изобретением компьютеров появилась возможность хранить на машинных носителях громадные объемы информации. Но для ее эффективного использования необходимо определить такие структуры организации информации, чтобы существовала возможность быстрого поиска, извлечения, записи, модификации информационной базы.

При машинном хранении структурной единицей информации является один байт, содержащий восемь бит (двоичных единиц информации). Менее определенной, но также переводимой в байты является неделимая единица экономической информации — реквизит.

Реквизиты объединяются в показатели, показатели — в записи, записи — в массивы, из массивов создаются комплексы массивов, а из комплексов — информационные базы. Структурная теория позволяет на логическом уровне построить оптимальную структуру информационной базы, которая затем с помощью определенных средств реализуется на физическом уровне — уровне технических устройств хранения информации. От выбранной структуры хранения зависит такой важный параметр, как время доступа к данным, т. е. структура влияет на время записи и считывания информации, а значит, и на время создания и реорганизации информационной базы.

Информационная база совместно с системой управления базой данных (СУБД) формирует автоматизированный банк данных.

Значение структурной теории информации растет при переходе от банков данных к банкам знаний, в которых информация подвергается еще более высокой степени структуризации.