Многослойный Персептрон.

Популярные нейросетевые архитектуры

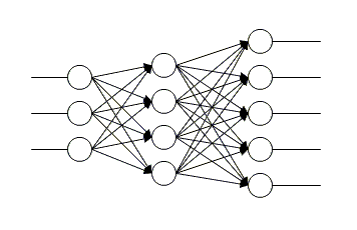

На схеме изображена двухслойная нейросеть — хотя можно использовать произвольное число слоёв, но обычно используются два. Существует теорема о том, что для любой n-слойной сети (n>2), можно построить эквивалентную ей двухслойную сеть. На практике иногда используют больше двух слоёв — в некоторых случаях это может сократить суммарное число нейронов. В двухслойной сети первый слой ассоциативных… Читать ещё >

Многослойный Персептрон. Популярные нейросетевые архитектуры (реферат, курсовая, диплом, контрольная)

Сразу после краха персептрона Розенблата начались попытки создать нейросеть без свойства линейной разделимости. Основной идеей являлось увеличение количества слоёв ассоциативных нейронов, однако долгое время не существовало алгоритма обучения таких сетей. Первым алгоритмом обучения многослойной нейросети был алгоритм обратного распространения ошибки (error back propagation). Итак опишем многослойный персептрон и методы его обучения.

Модель нейрона претерпела изменения. Теперь нейроны рецепторы принимают на вход действительные числа (обычно от 0 до1), а ассоциативные нейроны используют сигмоидальную функцию преобразования.

Как видно из модели нейрона многослойный персептрон работает с действительными числами. Отметим несколько важных свойств функции преобразования.

- 1. Областью значений функции является интервал (0,1).

- 2. Функция бесконечное число раз непрерывно дифференцируема.

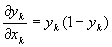

- 3. Её производная выражается только через неё саму: f' = f (1 — f) .

Структура связей в многослойном персептроне весьма похожа на структуру классического персептрона Розенблата. Имеется один слой нейронов рецепторов и произвольное число слоёв ассоциативных нейронов. Нейроны одного и того же слоя друг с другом не связаны, и каждый нейрон связан со всеми нейронами последующего слоя (кроме последнего слоя — его выходы являются выходами сети в целом).

На схеме изображена двухслойная нейросеть — хотя можно использовать произвольное число слоёв, но обычно используются два. Существует теорема о том, что для любой n-слойной сети (n>2), можно построить эквивалентную ей двухслойную сеть. На практике иногда используют больше двух слоёв — в некоторых случаях это может сократить суммарное число нейронов. В двухслойной сети первый слой ассоциативных нейронов обычно называют скрытым слоем, а второй — выходным.

Как видно из архитектуры k-слойная нейросеть производит цепочку отображений. Существует теорема утверждающая, что многослойная нейронная сеть может с любой заданной точностью приближать произвольную кусочно-непрерывную и ограниченную функцию (мы не будем приводить доказательство).

Обучение многослойного персептрона происходит по схеме «обучение с наставником». Опишем самый популярный метод обучения многослойного персептрона — метод обратного распространения ошибки. Сначала изложим основную идею метода. Итак, мы хотим изменять веса связей нейронов пропорционально их вкладу в ошибку. Для последнего слоя вычисление ошибки довольно очевидное действие, но как вычислить ошибку для предыдущих слоёв? Главной идеей метода обратного распространения ошибки является предположение, что ошибка распространяется по нейросети в обратном направлении (от выхода к входам). То есть вклад веса связи в ошибку пропорционален значению проходящего по связи сигнала и ошибке (дальнего по ходу сигнала) нейрона. Таким образом ошибка связи двух нейронов зависит от ошибки ближнего к выходу сети нейрона и прошедшего по связи сигнала. Ошибка как бы распространяется от выходов к входам — отсюда и название метода. Опишем его в точных математических терминах. Пускай у нас есть обучающая выборка из пар (Xб, Yб), б=1,2,., p. Будем использовать для обучения метод градиентного спуска:

- 1. Пусть W — матрица весов связей нейронов скрытого слоя, V — матрица весов выходного слоя. Придадим им в начальный момент случайные значения

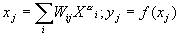

- 2. Пускай на входной образ Xб сеть вырабатывает выходной образ. Запишем как функционирует скрытый слой:

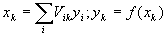

и выходной слой:

3. В качестве функционала подлежащего минимизации методом градиентного спуска возьмём среднеквадратичное отклонение реального выхода сети от предполагаемого, то есть.

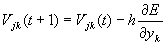

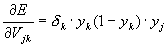

4. Начнём с выходного слоя. Согласно методу градиентного спуска.

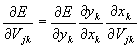

где h — темп обучения. Так как.

воспользовавшись правилами неявного дифференцирования получим.

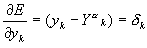

Вычислим.

Используя свойство 3 сигмоидальной функции активации вычислим.

Так же очевидным является равенство.

Итак мы получили.

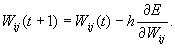

5. Теперь перейдём к скрытому слою. Опять по методу градиентного спуска имеем:

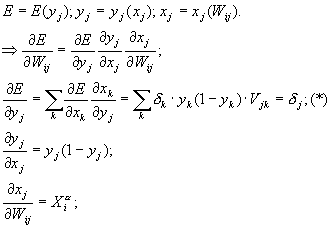

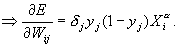

6. Как и на предыдущем шаге применяя формулы неявного дифференцирования и свойства сигмоды вычислим.

- 7. В формуле (*) для вычисления ошибки нейрона скрытого слоя и раскрывается главный смысл метода обратного распространения ошибки о котором мы говорили выше.

- 8. В случае наличия более двух слоёв к ним применяются все те же методы и принципы, мы не будем их описывать.

- 9. Далее, согласно концепции обучения с наставником, мы повторяем шаги 2−6 пока для всех обучающих образов суммарная ошибка не станет ниже некоторого фиксированного малого числа.

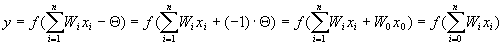

Можно было заметить, что мы проводили все вычисления с параметром функции преобразования И = 0. Это было сделано для упрощения. Как же нам учесть его? Легко заметить, что параметр И можно заменить, так называемым, фиктивным входом x0 = -1 с весом W0 = И. Таким образом для любого нейрона выход равен.

Итак, введя фиктивный вход, мы можем применить вышеописанный метод просто начиная все суммирование с нуля и учитывая в конце смысл W0.

Сложность этого алгоритма линейная от числа нейронов, то есть. Главными недостатками метода являются:

- · Медленная сходимость (свойство метода градиентного спуска).

- · В силу применения метода градиентного спуска, функционал среднеквадратичной ошибки минимизируется к локальному, а не к глобальному минимуму. В большинстве случаев этого достаточно, но если найденный локальный минимум недостаточен, то возможным выходом может быть попытка повторить обучение придав матрицам V и W другие значения на первом шаге.

- · Подстраивая веса и минимизируя ошибку для одного из обучающих векторов, мы можем её увеличивать для другого. Поэтому метод может, вообще говоря, не сойтись. Однако, практика показала, что такие случаи крайне редки.

После появления метода обратного распространения ошибки было придумано много других методов: стохастические, генетические и т. д. Всех их объединяет идея впервые использованная в методе обратного распространения ошибки: подход к обучению нейросети, как к задачи многомерной оптимизации.

На сегодняшний день многослойный персептрон — одна из самых популярных и используемых нейросетей. Причин успеха немало. Одно из главных преимуществ многослойного персептрона, это возможность решать алгоритмически неразрешимые задачи или задачи, для которых алгоритмическое решение неизвестно, но для которых возможно составить репрезентативный набор примеров с известными решениями. Многослойный персептрон функционирует очень похоже на человека. При обучение нейросеть, за счёт своего внутреннего строения, выявляет закономерности в связи входных и выходных образов, тем самым как бы «обобщает» полученный на обучающей выборке опыт. В этой способности к обобщению и состоит основа привлекательности многослойного персептрона. Мы сами можем и не знать какова зависимость между входными и выходными образами, достаточно иметь большой набор векторов для которых известен ожидаемый выход. Вот небольшой список задач где успешно применялся многослойный персептрон:

- · Прогнозирование поведения рынка

- · Распознавание речи

- · Анализ изображений

- · Экспертные системы

- · И т.д.