Статистическая мера информации

Энтропия равна нулю в том и только в том случае, когда вероятность одного события равна единице, а остальных — нулю. Это соответствует случаю, когда исход опыта может быть предсказан с полной достоверностью. Заметим, что выбор основания системы логарифмов несущественен, т. к. (в силу известной формулы oghk = log, а • ogak) переход от одной системы логарифмов к другой сводится лишь к умножению… Читать ещё >

Статистическая мера информации (реферат, курсовая, диплом, контрольная)

В данной мере информация рассматривается как сообщение об исходе случайных событий, реализации случайных величин, функций, а количество информации ставится в зависимость от априорных (доопытных) вероятностей этих событий, величин, функций. Когда приходит сообщение о часто встречающихся событиях, вероятность появления которых стремится к единице, то такое сообщение малоинформативно. Если же приходит сообщение о наступлении события, вероятность которого мала, то сообщение информативно. Главным свойством случайных событий является отсутствие полной уверенности в их наступлении, создающее известную неопределенность. Для практики важно уметь численно оценивать степень неопределенности самых разнообразных событий, чтобы иметь возможность сравнивать их с этой стороны.

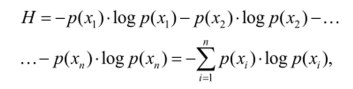

Клодом Элвудом Шенноном было предложено принять в качестве меры неопределенности события (опыта) с возможными исходами х, х2, …, х" величину Н, называемую энтропией:

гдер (х), р (х2), …, р (хп) — вероятность отдельных исходов.

Поскольку строгое определение вероятности будет даваться в курсах, изучаемых студентами данной специальности позднее, введём понятие вероятности.

Рассмотрим следующий опыт. Пусть мы бросаем монету. При проведении бросаний какое-то количество раз она будет падать гербом вверх, какое-то количество раз — цифрой вверх. Если мы бросим монету 10 раз, то в 3 случаях может выпасть герб, а в 7 — цифра. При бросании монеты 100 раз, герб может выпасть 40 раз, цифра — 60 раз.

Если бросать монету 1000 раз, то, скорее всего, герб выпадет 499 раз, а цифра 501 раз.

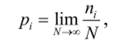

Вероятность наступления некоторого события равна отношению числа равновероятностных исходов, благоприятных для данного события, к общему числу равновероятных событий, т. е.

где я, — число положительных исходов опыта (например, выпадений герба);

N — общее число испытаний.

Заметим, что выбор основания системы логарифмов несущественен, т. к. (в силу известной формулы oghk = log, а • ogak) переход от одной системы логарифмов к другой сводится лишь к умножению на модуль перехода log, а.

Рассмотрим некоторые свойства энтропии, используемые в данном курсе:

- 1. Энтропия всегда неотрицательна, т. к. значения вероятностей выражаются дробными величинами, а логарифмы величин, меньших единицы, — отрицательными числами, гак что под знаком суммы получается отрицательная величина, а перед знаком суммы стоит знак минус, а минус умножить на минус дает плюс.

- 2. Энтропия равна нулю в том и только в том случае, когда вероятность одного события равна единице, а остальных — нулю. Это соответствует случаю, когда исход опыта может быть предсказан с полной достоверностью.

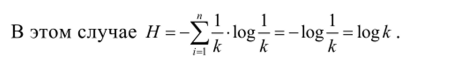

- 3. Энтропия имеет наибольшее значение при условии, когда все

вероятности равны между собой: /?(*,) = р (х2) =… = /?(**) = —.

к

к

Итак, максимальная энтропия равна Япих = log к.

Количество информации / в статистической мере о некотором объекте равно разности априорной Я, и апостериорной Н2 энтропий объекта:

где Н — априорная (до проведения опыта) энтропия;

#2 ~ апостериорная (после проведения опыта) энтропия.

Если неопределенность ситуации снимается полностью, то Н2 = О п.

и I = H = -J^p (xi)ogp (xi).

1=1.

Данная формула и является выражением для подсчёта количества информации статистической мерой. Основание логарифма определяет единицу измерения количества информации. При двоичном логарифме единица измерения — бит (binary digital) — по названию совпадает с битом по Хартли. Статистическую меру информации имеет смысл использовать лишь при теоретической оценке пропускной способности линий связи. Для указания объёма памяти используется бит, определённый Хартли.