Устранение автокорреляции случайных составляющих

2] 2 2 В силу ряда причин в регрессионных моделях может иметь место корреляционная зависимость между соседними случайными отклонениями. Этонарушает одну из фундаментальных предпосылок МНК. Вследствие этогооценки коэффициентов регрессии, полученные на основе МНК, перестаютбыть эффективными. Последнее делает ненадежными выводы как по значимости коэффициентов регрессии, так и по качеству самого… Читать ещё >

Устранение автокорреляции случайных составляющих (реферат, курсовая, диплом, контрольная)

Как говорилось в самом начале главы, основной причиной наличия случайного члена в модели являются несовершенные знания о причинах и взаимосвязях, определяющих то или иное значение зависимой переменной. Поэтому свойства случайных отклонений, в том числе и автокорреляция, в первую очередь зависят от выбора математической модели уравнения регрессии и состава объясняющих переменных. Чаще всего автокорреляция вызывается неправильной спецификацией модели, поэтому необходимо прежде всего скорректировать саму модель. Если все разумные процедуры изменения спецификации модели исчерпаны, а автокорреляция имеет место, то можно предположить, что она обусловлена какими-то внутренними свойствами ряда остатков {et}. В этом случае можно воспользоваться авторегрессионным преобразованием. Обычно наиболее целесообразным и простым преобразованием является авторегрессионная схема первого порядка AR ( 1).

Рассмотрим модель парной линейной регрессии.

Тогда наблюдениям t и (t — 1) соответствуют формулы  и.

и.

Пусть случайные отклонения подвержены воздействию авторегрессии первого порядка = per_1 + vv где vt — случайные отклонения, удовлетворяющие всем предпосылкам МНК, а коэффициент р известен. Вычтем из равенства (6.8) соотношение (6.9), умноженное на р:

где

Так как по предположению коэффициент р известен, то очевидно, что у*, х*п Pq, vt вычисляются достаточно просто. В силу того что случайные отклонения vt удовлетворяют предпосылкам МНК, оценки Pq и Pj будут обладать свойствами наилучших линейных несмещенных оценок.

Рассмотренное авторегрессионное преобразование может быть обобщено на любое число объясняющих переменных, следовательно, применимо для устранения автокорреляции во множественном уравнении линейной регрессии.

На практике значение коэффициента р обычно неизвестно, и его необходимо оценивать. Существует ряд методов оценивания этого коэффициента. Приведем некоторые из них.

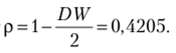

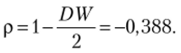

Определение р на основе статистики Дарбина — Уотсона. В качестве оценки коэффициента р может быть взят коэффициент корреляции тее =1-DW/2. Этот метод оценивания дает хорошие результаты при большом числе наблюдений. В этом случае оценка ree j коэффициента р будет достаточно точной.

Метод Хилдрета — Лу. По данному методу регрессия у* =(3q +Р, хг* +vt оценивается для каждого возможного значения р из отрезка [-1; 1] с любым шагом (например, 0,001; 0,01 и т. д.). Величина, дающая наименьшую стандартную ошибку регрессии, принимается в качестве оценки коэффициента р. Значения и Ь{ оцениваются из уравнения регрессии с данным значением р. Этот итерационный метод широко используется в пакетах компьютерных прикладных программ.

Метод первых разностей. Метод можно использовать в том случае, когда есть основание считать, что автокорреляция отклонений очень велика. Для временных рядов обычно характерна положительная автокорреляция остатков р > 0. Поэтому при высокой автокорреляции полагают р = 1, и уравнение регрессии принимает вид

Обозначив  получим.

получим.

Коэффициент Ь{ оценивается обычным МНК. Коэффициент доопределяется из соотношения

Замечание 6.2. Метод первых разностей предполагает слишком сильное упрощение (р = ±1). Поэтому более предпочтительными являются итерационные методы.

Пример 6.4.

Определим наличие автокорреляции по данным, приведенным в табл. 6.7, и устраним автокорреляцию, используя модель парной линейной регрессии и авторегрессионную схему первого порядка AR ( 1) (определение р произведем на основе статистики Дарбина — Уотсона).

Таблица 6.7

Исходные данные для примера 6.4.

i | ||||||||||

X | ||||||||||

У | ||||||||||

i | ||||||||||

X | ||||||||||

У | ИЗ. |

Решение. По МЫК находим уравнение регрессии: ух = -9,416 + 1,197 д,-.

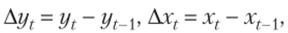

1. Графический метод. Строим зависимость остатков от номера наблюдения (табл. 6.8, столбец 5).

Результаты представлены на рис. 6.7. График зависимости отклонений et от номера наблюдений i говорит о положительном характере автокорреляции, т. е. с увеличением номера наблюдения разброс с, увеличивается. Наблюдается волнообразное поведение отклонений ev

Рис. 6.7. Графический метод для примера 6.4.

2. Проверка, но методу рядов.

Вычисляем все значения ух по уравнению регрессии и находим разности ех = у, — у, (см. табл. 6.8, столбцы 4 и 5). Подсчитываем количество знаков «плюс», «минус» и число рядов к: п = 20, пл = 9, п2 = 11, к = 7. Для у = 0,95 из статистических таблиц находим кх = 6 и к2 = 16. Так как наше значение к попадает в промежуток 6 < к = 7 < 16, автокорреляция по методу рядов не обнаружена.

Таблица 6.8

Вычисления к примеру 6.4.

xi | Ух | А. Ух | *". | ei ei- | ef | («, — ei-1)2 | |

104,338. | — 1,338. | —. | 1,792. | —. | |||

92,364. | — 1,364. | — 0,025. | 1,861. | 0,001. | |||

136,669. | 2,330. | 3,695. | 5,431. | 13,653. | |||

74,403. | — 1,403. | — 3,733. | 1,968. | 13,940. | |||

77,995. | — 1,995. | — 0,592. | 3,981. | 0,350. | |||

83,982. | — 0,982. | 1,013. | 0,965. | 1,026. | |||

89,969. | — 0,969. | 0,013. | 0,940. | 0,001. | |||

93,562. | 1,438. | 2,407. | 2,067. | 5,797. | |||

97,154. | 2,845. | 1,407. | 8,098. | 1,981. | |||

105,536. | 1,464. | — 1,382. | 2,142. | 1,909. | |||

105,536. | 2,464. | 1,0. | 6,069. | 1,0. | |||

ИЗ. | 113,918. | — 0,918. | — 3,382. | 0,843. | 11,437. | ||

121,103. | — 2,102. | — 1,184. | 4,422. | 1,403. | |||

124,695. | — 3,695. | — 1,592. | 13,654. | 2,535. | |||

127,090. | — 5,090. | — 1,394. | 25,908. | 1,945. | |||

128,287. | 2,712. | 7,802. | 7,357. | 60,880. | |||

131,879. | 3,120. | 0,407. | 9,736. | 0,166. | |||

81,587. | 4,412. | 1,292. | 19,468. | 1,669. | |||

89,969. | 2,030. | — 2,382. | 4,122. | 5,673. | |||

95,956. | — 2,956. | — 4,987. | 8,742. | 24,871. | |||

Сумма. | 129,576. | 150,244. | |||||

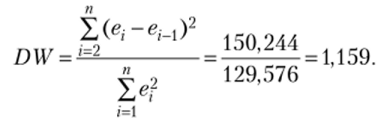

3. Проверка по критерию Дарбина — Уотсона.

Заполняем столбцы 6—8 табл. 6.8. Из каждого значения в 5-м столбце вычитаем предыдущее значение и результат заносим в 6-й столбец. Подсчитываем квадраты остатков и квадраты разностей (7-й и 8-й столбцы).

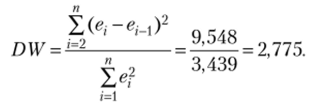

Статистика Дарбина — Уотсона:

Для п = 20, т = 1 (число объясняющих параметров), у = 0,95 по статистическим таблицам Дарбина — Уотсона находим dL = 1,201 и dv = 1,411. Так как DW < dL, это свидетельствует о положительной автокорреляции остатков.

Замечание 6.3. Если хотя бы один из методов показал наличие автокорреляции, гипотеза об отсутствии автокорреляции отвергается.

4. Устранение автокорреляции.

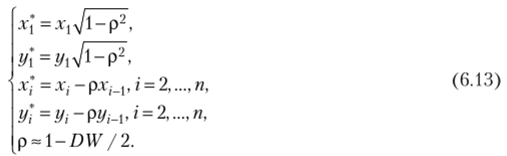

Используем авторегрессонную схему первого порядка AR ( 1). Вместо переменных .г, у рассмотрим новые переменные х", у , значения которых вычисляются по следующему правилу:

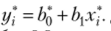

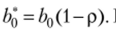

Пусть Ь'й = />0(1 — р). Коэффициент  С помощью обычного МНК по переменным х* и у* оцениваем коэффициенты уравнения

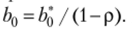

С помощью обычного МНК по переменным х* и у* оцениваем коэффициенты уравнения  Далее находим Ь0 =Ь$ / (1 — р). Результаты вычислений приведены в табл. 6.9.

Далее находим Ь0 =Ь$ / (1 — р). Результаты вычислений приведены в табл. 6.9.

Устранение автокорреляции к примеру 6.4.

Таблица 6.9

i | X | У | X* | У‘. |

87,274. | 94,622. | |||

47,469. | 50,309. | |||

88,420. | 103,049. | |||

21,803. | 18,087. | |||

45,346. | 47,161. | |||

49,160. | 52,975. | |||

52,185. | 56,210. | |||

53,210. | 59,839. | |||

55,025. | 62,469. | |||

60,839. | 67,494. | |||

58,074. | 65,728. | |||

65,074. | 70,334. | |||

68,309. | 74,358. | |||

68,938. | 73,988. | |||

69,753. | 74,198. | |||

69,963. | 82,803. | |||

72,568. | 83,247. | |||

29,383. | 32,667. | |||

52,976. | 58,025. | |||

55,210. | 56,654. |

Определенные по МНК значения /;, = 1,219, = -6,653. Значение

Полученное уравнение регрессии у(-нов =—11,476 + 1,219*( (сравните с первоначальным уравнением регрессии у, =-9,416+1,197*,-).

Пример 6.5.

Определим наличие автокорреляции по данным, приведенным в табл. 6.10, и устраним автокорреляцию, используя модель парной линейной регрессии и авторегрессионную схему первого порядка Л7?(1) (определение р произведем на основе статистики Дарбина — Уотсона).

Таблица 6.10

Исходные данные для примера 6.5.

i | |||||||||||||

X | 2,31. | 3,3. | 2,37. | 2,87. | 2,53. | 3,14. | 3,26. | 2,31. | 2,46. | 2,28. | 2,88. | 2,46. | 2,9. |

У | 2,5. | 2,1. | 2,8. | 2,79. | 2,87. | 2,8. | 2,1. | 3,63. | 1,93. | 2,93. | 2,11. | 3,24. | 2,09. |

i | |||||||||||||

X | 2,75. | 2,29. | 2,99. | 2,8. | 2,29. | 3,28. | 2,84. | 3,06. | 3,17. | 2,98. | 2,28. | 2,29. | |

У | 2,77. | 2,1. | 2,54. | 2,5. | 3,43. | 1,93. | 2,58. | 2,41. | 2,11. | 2,25. | 3,1. |

По MI1K находим уравнение регрессии:=4,732−0,788*,.

1. Проверка по методу рядов.

Вычисляем все значения у, по уравнению регрессии и находим разности е, = у, — у, (см. табл. 6.11, столбцы 4 и 5). Подсчитываем количество знаков «плюс», «минус» и число рядов к п = 25, щ = 12, п2 = 13, к = 16. Для у = 0,95 из статистических таблиц находим /г, = 8 и к2 =19. Так как наше значение к попадает в промежуток 8 < к = 16 < 19, автокорреляция по методу рядов не обнаружена.

Таблица 6.11

Вычисления к примеру 6.5.

i | У, | У, | е, — е,_. | (е,-ем)2 | |||

2,31. | 2,5. | 2,911. | — 0,411. | ; | 0,168. | ; | |

3,3. | 2,1. | 2,129. | — 0,029. | 0,380. | 0,001. | 0,145. | |

2,37. | 2,8. | 2,863. | — 0,063. | — 0,033. | 0,004. | 0,001. | |

2,87. | 2,79. | 2,468. | 0,321. | 0,384. | 0,103. | 0,147. | |

2,53. | 2,87. | 2,737. | 0,133. | — 0,188. | 0,017. | 0,035. | |

3,14. | 2,8. | 2,256. | 0,544. | 0,411. | 0,296. | 0,168. | |

3,26. | 2,1. | 2,161. | — 0,061. | — 0,605. | 0,004. | 0,366. | |

2,31. | 3,63. | 2,911. | 0,719. | 0,781. | 0,517. | 0,609. | |

2,46. | 1,93. | 2,792. | — 0,862. | — 1,582. | 0,743. | 2,502. | |

2,28. | 2,93. | 2,934. | — 0,004. | 0,858. | 1,7?-05. | 0,736. | |

2,88. | 2,11. | 2,461. | — 0,351. | — 0,346. | 0,123. | 0,120. |

i | *1. | Уг | Уг | *"" ei-i | (е, — e,-i)2 | ||

2,46. | 3,24. | 2,792. | 0,447. | 0,798. | 0,200. | 0,638. | |

2,9. | 2,09. | 2,445. | — 0,355. | — 0,803. | 0,126. | 0,645. | |

2,75. | 2,77. | 2,564. | 0,206. | 0,562. | 0,042. | 0,315. | |

2,29. | 2,1. | 2,926. | — 0,826. | — 1,033. | 0,682. | 1,066. | |

2,99. | 2,54. | 2,374. | 0,166. | 0,992. | 0,027. | 0,983. | |

2,8. | 2,5. | 2,524. | — 0,024. | — 0,189. | 0,001. | 0,036. | |

2,29. | 3,43. | 2,926. | 0,504. | 0,528. | 0,2537. | 0,278. | |

3,28. | 1,93. | 2,145 666. | — 0,215. | — 0,719. | 0,046. | 0,517. | |

2,84. | 2,58. | 2,492 616. | 0,087. | 0,303. | 0,007. | 0,092. | |

3,06. | 2,41. | 2,319 141. | 0,091. | 0,003. | 0,008. | 1,2?-05. | |

3,17. | 2,11. | 2,232 403. | — 0,122. | — 0,213. | 0,015. | 0,045. | |

2,98. | 2,25. | 2,382 223. | — 0,132. | — 0,009. | 0,017. | 9,6?-05. | |

2,28. | 3,1. | 2,934 189. | 0,166. | 0,298. | 0,027. | 0,088. | |

2,29. | 2,926 304. | 0,073. | — 0,092. | 0,005. | 0,008. | ||

Сумма. | 3,439. | 9,548. | |||||

2. Проверка по критерию Дарбина — Уотсона.

Заполняем столбцы 6—8 табл. 6.11. Из каждого значения в 5-м столбце вычитаем предыдущее значение и результат заносим в 6-й столбец. Подсчитываем квадраты остатков и квадраты разностей (7-й и 8-й столбцы).

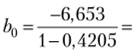

Статистика Дарбина — Уотсона:

Для п = 25, т = 1 (число объясняющих параметров), у = 0,95 но статистическим таблицам Дарбина — Уотсона находим dL = 1,29 и dv= 1,45. Так как DW> 4 — dUtэто свидетельствует об отрицательной автокорреляции остатков (см. рис. 6.3).

4. Устранение автокорреляции.

Используем авторегрессионную схему первого порядка ЛR (). Вместо переменных х, у рассмотрим новые переменные х*> у*, значения которых вычисляются по правилу (6.13).

Пусть  Коэффициент

Коэффициент  С помощью обычного МНК.

С помощью обычного МНК.

по переменным х* и у* оцениваем коэффициенты уравнения у] = + Ь{х*. Далее находим Результаты вычислений приведены в табл. 6.12.

Таблица 6.12

Устранение автокорреляции к примеру 6.5.

*. | ||||

i | X | У | X | У |

2,31. | 2,5. | 2,129. | 2,304. | |

3,3. | 2,1. | 4,196. | 3,069. |

i | X | У | ЛГ*. | *. У |

2,37. | 2,8. | 3,650. | 3,614. | |

2,87. | 2,79. | 3,789. | 3,876. | |

2,53. | 2,87. | 3,643. | 3,952. | |

3,14. | 2,8. | 4,122. | 3,913. | |

3,26. | 2,1. | 4,478. | 3,186. | |

2,31. | 3,63. | 3,575. | 4,445. | |

2,46. | 1,93. | 3,356. | 3,338. | |

2,28. | 2,93. | 3,234. | 3,678. | |

2,88. | 2,11. | 3,764. | 3,246. | |

2,46. | 3,24. | 3,577. | 4,058. | |

2,9. | 2,09. | 3,854. | 3,347. | |

2,75. | 2,77. | 3,875. | 3,581. | |

2,29. | 2,1. | 3,357. | 3,175. | |

2,99. | 2,54. | 3,878. | 3,355. | |

2,8. | 2,5. | 3,959. | 3,485. | |

2,29. | 3,43. | 3,376. | 4,399. | |

3,28. | 1,93. | 4,168. | 3,261. | |

2,84. | 2,58. | 4,112. | 3,328. | |

3,06. | 2,41. | 4,162. | 3,411. | |

3,17. | 2,11. | 4,357. | 3,045. | |

2,98. | 2,25. | 4,209. | 3,068. | |

2,28. | 3,1. | 3,436. | 3,973. | |

2,29. | 3,174. | 4,203. |

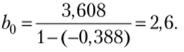

Определенные по МНК значения Ь, = -0,02, Ъ'0=3,608. Значение

Полученное уравнение регрессии у, мо" =2,6−0,02х( (сравните с первоначальным уравнением регрессии у-, =4,732−0,788х,).

Проверка нового уравнения регрессии по методу Дарбина — Уотсона показала DW = 1,594. Это свидетельствует об устранении автокорреляции остатков первого порядка.

Пример 6.6.

Определим наличие автокорреляции по данным, приведенным в табл. 6.13, и устраним автокорреляцию, используя модель множественной линейной регрессии и авторегрессионную схему первого порядка AR (1) (определение р произведем на основе статистики Дарбина — Уотсона).

Таблица 6.13

Исходные данные для примера 6.6.

i | ||||||||||

*2. | И. | |||||||||

*3. | и. | |||||||||

У | ||||||||||

i | ||||||||||

X] | ||||||||||

*2. | ||||||||||

Я’З. | ||||||||||

У |

По МНК находим уравнение регрессии:

1. Проверка по методу рядов.

Вычисляем все значения у, по уравнению регрессии и находим разности е, = у, — у, (табл. 6.14, столбцы 6 и 7). Подсчитываем количество знаков «плюс», «минус» и число рядов к: п = 20, щ = 9, п2 = 11, к = 8. Для у = 0,95 из статистических таблиц находим (| = 6и (2 = 16. Так как наше значение к попадает в промежуток 6 < /.

Таблица 6.14

Вычисления к примеру 6.6.

i. | *1. | х2 | *3. | У | У, | е? | («, ~ e,-i)2 | |

251,72. | 48,28. | 2330,54. | ||||||

326,26. | 73,74. | 5437,95. | 648,56. | |||||

281,19. | 18,81. | 353,71. | 3017,89. | |||||

314,23. | 5,77. | 33,32. | 169,92. | |||||

267,57. | — 67,57. | 4566,04. | 5379,41. | |||||

390,81. | — 40,81. | 1665,43. | 716,25. | |||||

340,56. | 9,44. | 89,10. | 2524,96. | |||||

345,03. | 54,97. | 3022,16. | 2073,43. | |||||

332,44. | 47,56. | 2262,02. | 54,96. | |||||

421,24. | — 21,24. | 451,11. | 4733,44. | |||||

277,28. | — 27,28. | 744,45. | 36,55. | |||||

334,55. | 15,45. | 238,68. | 1826,19. | |||||

217,49. | — 17,49. | 305,75. | 1084,71. | |||||

415,01. | — 15,01. | 225,42. | 6,11. |

г | *1. | Л~2 | *3. | У | У, | ei | е? | (е;" ем)2 |

222,38. | — 2,38. | 5,67. | 159,57. | |||||

334,55. | — 14,55. | 211,73. | 148,08. | |||||

396,50. | — 6,50. | 42,22. | 64,86. | |||||

355,21. | 4,79. | 22,90. | 127,29. | |||||

272,60. | — 12,60. | 158,86. | 302,38. | |||||

303,37. | — 53,37. | 2847,89. | 1661,50. | |||||

Сумма. | 25 014,93. | 24 736,05. | ||||||

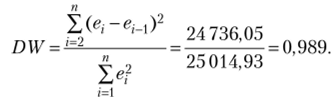

2. Проверка по критерию Дарбина — Уотсона.

Заполняем столбцы 8 и 9 табл. 6.14 (подсчитываем квадраты остатков и квадраты разностей).

Статистика Дарбина — Уотсона.

Для п = 20, т = 3 (число объясняющих параметров), у = 0,95 по статистическим таблицам Дарбина — Уотсона находим dL = 1,0 и dy= 1,68. Так как DW< dL, это свидетельствует об автокорреляции остатков.

3. Устранение автокорреляции.

Используем авторегрессонную схему первого порядка AR ( 1). Вместо переменных Xjj, у, рассмотрим новые переменные х1, у], значения которых вычисляются по формулам (6.12) и приведены в габл. 6.15. Значение р определяем по статистике DW: р = 0,505.

Таблица 6.15

Преобразование переменных.

i | *2. | *3. | У*. | |

25,02. | 5,18. | 12,94. | 258,83. | |

15,34. | 3,97. | — 0,58. | 248,33. | |

15,83. | 4,46. | 11,46. | 97,77. | |

16,33. | 5,96. | 6,42. | 168,33. | |

15,82. | — 0,06. | 5,92. | 38,22. | |

28,82. | 8,47. | 5,43. | 248,89. | |

10,25. | 4,44. | 4,93. | 173,05. | |

18,32. | 3,94. | 4,44. | 223,05. | |

18,30. | 8,45. | 12,94. | 177,77. | |

14,80. | 7,43. | — 3,10. | 207,88. | |

13,32. | 0,92. | 11,97. | 47,77. | |

15,83. | 10,96. | 10,42. | 223,61. |

i | ЛТ|. | х’з | ". У | |

14,33. | 0,42. | 13,90. | 23,05. | |

16,83. | 15,96. | 3,37. | 298,89. | |

13,82. | — 5,11. | 10,42. | 17,77. | |

15,83. | 12,47. | 8,90. | 208,77. | |

17,33. | 12,42. | 8,90. | 228,22. | |

15,32. | 9,89. | 13,90. | 162,83. | |

12,82. | — 0,11. | 6,37. | 77,99. | |

10,34. | 0,94. | — 3,10. | 118,55. |

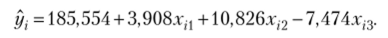

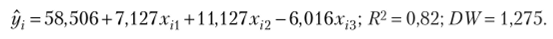

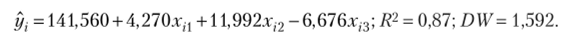

Уравнение регрессии, полученное по новым переменным (п = 20):

Уравнение регрессии, полученное по новым переменным без первого наблюдения (п = 19):

Ответ. В обоих случаях автокорреляция первого порядка не обнаружена.

- [1] Замечание 6.4. При большом числе наблюдений, как в примере 6.6,допускается опускать первое наблюдение. При малом числе наблюдений (меньше 10) первое наблюдение исключать нельзя.

- [2] 2 2 В силу ряда причин в регрессионных моделях может иметь место корреляционная зависимость между соседними случайными отклонениями. Этонарушает одну из фундаментальных предпосылок МНК. Вследствие этогооценки коэффициентов регрессии, полученные на основе МНК, перестаютбыть эффективными. Последнее делает ненадежными выводы как по значимости коэффициентов регрессии, так и по качеству самого уравнения. Поэтому достаточно важным является умение определить наличие автокорреляции. Существует несколько методов определения автокорреляции, среди которых были выделены графический метод, метод рядов, критерийДарбина — Уотсона. При установлении автокорреляции необходимо в первую очередь проанализировать правильность спецификации модели. Если после ряда возможных усовершенствований регрессии автокорреляция по-прежнемуимеет место, то, возможно, это связано с внутренними свойствами рядаотклонений. В этом случае возможны некоторые преобразования, устраняющие автокорреляцию. Среди них выделяется авторегрессионная схемапервого порядка Л/?(1). Для применения указанных схем необходимо оценить коэффициент корреляции между отклонениями. Это может бытьсделано различными методами: на основе статистики Дарбина — Уотсона, Хилдрета — Лу и др.