Сети встречного распространения

Сеть СВР состоит из двух слоев без обратных связей и связей нейронов внутри слоя. Первый слой является слоем нейрона Кохонена. Входной вектор сети подается на все нейрона слоя Кохонена. Второй слой является слоем нейронов Гроссберга. Каждый нейрон слоя Кохонена через соответствующие синаптические связи соединен с каждым нейроном слоя Гроссберга. Выходы нейронов второго слоя образуют вектор… Читать ещё >

Сети встречного распространения (реферат, курсовая, диплом, контрольная)

Сеть встречного распространения (СВР) была предложена Робертом Хехт-Нильсеном в 1987 г. Сети встречного распространения характеризуются существенно меньшим временем обучения, чем слоистые сети, использующие алгоритм обратного распространения ошибки. Сети данного типа объединяют две известные модели НС: самоорганизующиеся карты Кохонена и сети Гроссберга. Такое объединение позволило достигнуть новых свойств, которых нет ни у одной из них в отдельности. Комбинирование различных моделей НС позволяет построить модели, более близкие к мозгу по архитектуре. Сеть СВР обладает хорошей обобщающей способностью.

Сеть СВР состоит из двух слоев без обратных связей и связей нейронов внутри слоя. Первый слой является слоем нейрона Кохонена. Входной вектор сети подается на все нейрона слоя Кохонена. Второй слой является слоем нейронов Гроссберга. Каждый нейрон слоя Кохонена через соответствующие синаптические связи соединен с каждым нейроном слоя Гроссберга. Выходы нейронов второго слоя образуют вектор выходных сигналов сети (рис. 5.12).

Каждый элемент сети u (n) характеризуется собственным набором коэффициентов связи, по которым к нему поступает входной сигнал x (t)=xk(t), k=1,N: w (n, t)=wk(n, t), k=1,N.

В процессе обучения сети предъявляются обучающие примеры (Ak, Dk), k=1,m. Слой Кохонена обучается по правилу Кохонена, слой Гроссберга — по Дельта-правилу.

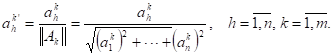

Нормализация входных векторов Перед началом обучения входные образы, как правило нормализуют, чтобы получился вектор с тем же направлением, но единичной длины. Для этого каждую компоненту входного вектора делят на длину вектора.

(7.1).

Выбор начальных значений весовых коэффициентов.

В простых реализациях весовым матрицам W(1) и W(2) на этапе инициализации присваиваются случайные значения. Однако для слоя Кохонена такая процедура не является оптимальной. После начальной инициализации вектора синаптических весов будет распределяться равномерно по поверхности гиперсферы единичного радиуса. В то же время входные векторы, как правило, распределены неравномерно и могут быть сосредоточены на относительно малой части поверхности гиперсферы. Это может привести к тому, что часть весовых векторов будет так удалена от любого входного вектора, что никогда не приблизится к ним, т. е. будет иметь нулевой выход и фактически окажется бесполезной. Оставшихся же векторов может оказаться слишком мало, чтобы разделить входные образы на классы, которые могут быть слишком близко расположены друг к другу.

Более эффективным решением является начальное распределение весовых векторов в соответствии с плотностью распределения входных образов. На практике это не выполнимо, однако существуют методы приближенного достижения этой цели.

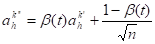

Метод выпуклой комбинации Все веса слоя Кохонена приравниваются одной и той же величине.

. (5.16).

Компонентом входных векторов Ак' присваиваются значения.

. (5.17).

Т.о., вектор синаптических весов отслеживают один или небольшую группу близких векторов, постепенно приближающихся к своим истинным значениям.

Активационная функция в процессе функционирования сети является линейной с =0 как для нейронов Кохонена, так и для нейронов Гроссберга. Для всего слоя Кохонена дополнительно вычисляется общая функция от значения активности нейронов этого слоя. Эти функции соответствуют функциям выбора нейрона для модификации весового вектора (либо нейрон с максимальным выходным значением, либо с наименьшим расстоянием между вектором входных значений в p-мерном пространстве, либо функция SoftMax).

Если в процессе функционирования СВР в слое Кохонена активизируется один нейрон, то говорят, что СВР работает по методу аккредитации (рис. 5.14). Если активизируется группа нейронов используется метод интерполяции. В этом случае вектор выходов нейронов группы нормализуется и используется далее для вычисления выходов нейронов Гроссберга. Метод интерполяции позволяет реализовать более сложные ассоциации образов.