Понятие неопределенности, энтропии и количества информации

Энтропия является мерой неопределенности системы (случайной величины) X. Она не зависит от состояний системы (значений случайной величины) х-{, а определяется только их вероятностями. Энтропия в некотором смысле представляет минимальный объем памяти, необходимый для записи информации, содержащейся в случайной величине. Пример 3.18. Информационная система в процессе эксплуатации может находиться… Читать ещё >

Понятие неопределенности, энтропии и количества информации (реферат, курсовая, диплом, контрольная)

Черты случайности, присущие процессам передачи информации, заставляют обратиться при изучении этих процессов к вероятностным методам. Поэтому теорию информации — науку, изучающую закономерности получения, передачи, обработки и хранения информации, — рассматривают как прикладную науку, применяющую вероятностные методы исследования, а иногда даже как раздел теории вероятностей.

Рассмотрим физическую систему X, которая случайным образом может оказаться в одном из возможных состояний, т. е. систему, которой заведомо присуща некоторая степень неопределенности. Информация представляет сообщение, уменьшающее степень неопределенности системы, которая, очевидно, определяется как числом возможных состояний системы, так и вероятностями состояний.

В качестве меры неопределенности системы (случайной величины) X используется энтропия.

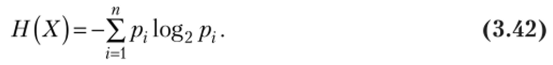

Определение. Энтропией системы (дискретной случайной

величины) называется сумма произведений вероятностей различных

состояний системы {значений случайной величины) на логарифмы этих

вероятностей, взятая со знаком1 «минус»:

(Считается, что 0 • к^2 0 = 0.).

Основание логарифма — это по существу единица измерения энтропии. Наиболее часто используется двоичный логарифм (по основанию два), тогда единицей измерения выступает бит.

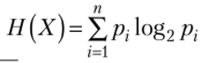

Следует заметить, что энтропия может быть представлена в форме математического ожидания:

Выражение (3.43) в ряде случаев позволяет упрощать преобразования, связанные с энтропией, используя известные свойства математического ожидания.

Энтропия является мерой неопределенности системы (случайной величины) X. Она не зависит от состояний системы (значений случайной величины) х-{, а определяется только их вероятностями. Энтропия в некотором смысле представляет минимальный объем памяти, необходимый для записи информации, содержащейся в случайной величине.

Рассмотрим свойства энтропии.

1. Энтропия Н (Х) равна нулю, когда одно из состояний системы достоверно.

? Пусть, например,  ?

?

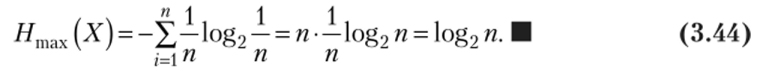

- 2. При заданном числе состояний п энтропия максимальна, когда эти состояния равновозможны, и равна логарифму числа состояний.

- ? Исследуя (методом множителей Лагранжа[1][2]) на условный экстремум

функцию  при условии, что

при условии, что  можно доказать, собой значениях т. е. при При этом максичто экстремум (в данном случае минимум) достигается при равных между.

можно доказать, собой значениях т. е. при При этом максичто экстремум (в данном случае минимум) достигается при равных между.

мальная энтропия.

3. При объединении независимых систем (систем, принимающих свои состояния независимо одна от другой) их энтропии складываются:

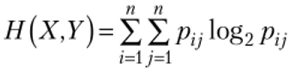

где  — энтропия объединения (Х, У) систем X и У С ВОЗМОЖНЫМИ СОСТОЯНИЯМИ Х{, х2, хп, Уь У2у …" уп> т. е. энтропия сложной системы (Х, У), состояния которой (х^) представляют собой все возможные комбинации состояний х-1У у} систем X и У.

— энтропия объединения (Х, У) систем X и У С ВОЗМОЖНЫМИ СОСТОЯНИЯМИ Х{, х2, хп, Уь У2у …" уп> т. е. энтропия сложной системы (Х, У), состояния которой (х^) представляют собой все возможные комбинации состояний х-1У у} систем X и У.

Свойство 3 — свойство аддитивности энтропии может быть распространено на случай п независимых систем.

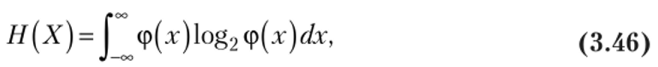

Рассмотренные свойства оправдывают выбор энтропии в качестве меры неопределенности состояний системы. Заметим, что для систем с непрерывным множеством состояний (значений) энтропия определяется следующим образом:

гдеср (.г) — плотность вероятности случайной величины X.

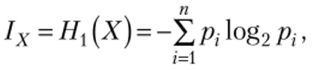

С понятием энтропии тесно связано количество информации, иод которым понимается изменение энтропии системы в результате получения сведений о системе:

где Н (Х) и Н2{Х) — энтропии системы соответственно до и после получения сведений о системе.

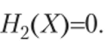

При полном выяснении системы количество информации 1Хравно энтропии этой системы  так как в этом случае

так как в этом случае

[> Пример 3.18. Информационная система в процессе эксплуатации может находиться в состояниях: х{ — полностью исправна; х2 — имеет незначительные неисправности; х3 — имеет существенные неисправности; хЛ — полностью вышла из строя. Найти:

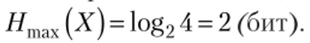

- а) вероятности состояний, при которых энтропия системы будет максимальной, а также эту энтропию:

- б) количество информации, приобретаемое об этой системе при полном выяснении ее состояния в случае, если вероятности состояний системы хи х2, х3, х4 равны соответственно 0,8; 0,1; 0,05; 0,05.

Решение, а) Энтропия системы максимальна, т. е. Н (Х) = Нтгх(Х)> когда состояния системы равновозможны, т. е. при р{ = р2 = р% ~Р-¼. По формуле (3.44)

б) При полном выяснении системы количество информации 1Хравно энтропии этой системы, т. е. 1Х = Я1(Х) = -0,8к^20,8−0,1к^20,1- - 0,05 log2 0,05 — 0,05 log2 0,05 = 1,02 (бит). ?